使用 Ollama 部署千问模型并搭建可视化交互界面教程

一、环境准备

1. 安装 Docker

确保你的系统上已经安装了 Docker。如果没有安装,可以前往 Docker 官方网站 下载并安装适合你操作系统的版本。

2. 安装 Python

推荐安装 Python 3.7 或更高版本。可以从 Python 官方网站 下载安装。

3. 安装 Git

用于克隆 Ollama 的代码仓库。可在 Git 官方网站 下载适合你操作系统的版本并安装。

二、安装 Ollama

1. 克隆 Ollama 仓库

打开命令行工具,输入以下命令以克隆 Ollama 的 GitHub 仓库:

git clone https://github.com/ollama/ollama.gitcd ollama2. 构建并运行 Ollama

在项目根目录下,运行以下命令以构建并启动 Ollama 服务:

docker build -t ollama .docker run -d -p 1143:1143 --name ollama ollama下载千问模型

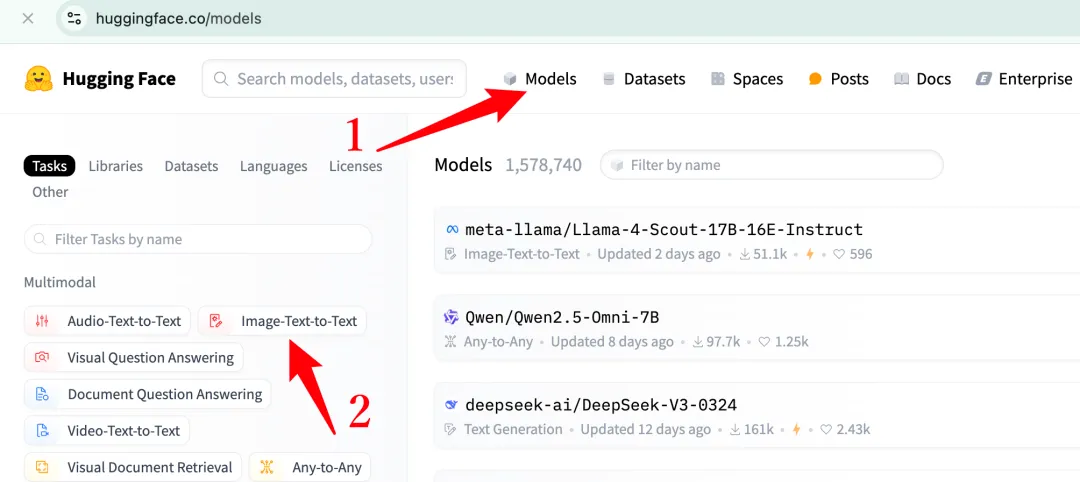

1. 获取千问模型

千问模型(Qwen-VL)的下载地址通常可以在其官方发布页面或模型仓库中找到。确保你下载的是与 Ollama 兼容的模型版本。

2. 加载模型到 Ollama

将下载好的千问模型文件放置在 Ollama 的模型目录中。默认情况下,模型目录位于

ollama/models。将模型文件解压并放置在相应的文件夹中。四、使用千问模型

1. 通过命令行使用

打开命令行工具,使用以下命令与千问模型进行交互:

ollama run qwen-vl --prompt "你的提示内容"例如,如果你想让模型描述一张图片,可以使用:

ollama run qwen-vl --prompt "请描述这张图片的内容: https://example.com/image.jpg"2. 通过 API 使用

你也可以通过 Ollama 提供的 API 接口来调用千问模型。以下是一个使用 Python 的示例:

import requests

url = "http://localhost:1143/v1/completions"headers = {

"Content-Type": "application/json",

"Authorization": "Bearer YOUR_API_KEY"}data = {

"model": "qwen-vl",

"prompt": "请描述这张图片的内容: https://example.com/image.jpg"}response = requests.post(url, headers=headers, json=data)print(response.json())五、部署可视化交互界面

1. 克隆可视化界面仓库

git clone https://github.com/AXYZdong/handy-ollamacd handy-ollama/notebook/C6/fastapi_chat_app2. 安装依赖

pip install -r requirements.txt

pip install 'uvicorn[standard]'3. 修改 app.py 代码

输入

vim websocket_handler.py 命令(确保你在 fastapi_chat_app 目录下),更改 model 代码如下:#!/usr/bin/env python# -*- coding: utf-8 -*-import ollamafrom fastapi import WebSocketasync def websocket_endpoint(websocket: WebSocket):

await websocket.accept()

user_input = await websocket.receive_text()

stream = ollama.chat(

model='qwen2.5:0.5b',

messages=[{'role': 'user', 'content': user_input}],

stream=True

)

try:

for chunk in stream:

model_output = chunk['message']['content']

await websocket.send_text(model_output)

except Exception as e:

await websocket.send_text(f"Error: {e}")

finally:

await websocket.close()4. 运行模型

输入命令:

uvicorn app:app --reload5. 打开可视化界面

在浏览器中打开

http://127.0.0.1:8000

即可开始与千问模型对话。

通过以上步骤,你已经成功使用 Ollama 部署了千问模型,并搭建了一个可视化的交互界面。希望这篇教程能够帮助你更好地利用千问模型的强大功能,提升你的工作效率和创造力。

还没有评论,来说两句吧...