DeepSeek本地部署与个人知识库搭建指南教程

环境准备与模型部署

1.安装Ollama框架

Ollama是支持跨平台运行大模型的核心工具,需根据操作系统选择安装方式:

macOS:终端执行 `curl -fsSL https://ollama.com/install.sh | sh`

Windows:从官网下载安装包并运行

Linux:通过脚本安装并启动服务(需Docker支持)

验证安装:执行 `ollama -v`,成功显示版本号即正常。

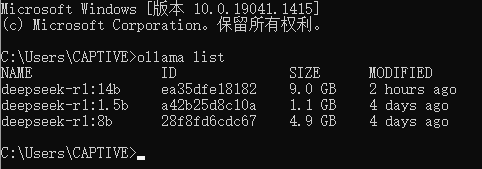

2. 下载DeepSeek模型

通过Ollama官方模型库获取模型:

ollama run deepseek-r1 # 默认下载7B版本,需14B或更高版本可调整参数

安装完成后,终端将进入交互模式,输入测试指令(如“用Python写快速排序”)验证模型运行。

3. 硬件配置建议

最低要求:16GB内存 + 8GB显存(如GTX 1080)

推荐配置:32GB内存 + 16GB显存(如RTX 3060及以上)。

交互界面配置

1. Chatbox本地客户端

- 下载Chatbox客户端,进入设置界面,选择“Ollama API”,配置地址为 `http://127.0.0.1:11434`,即可开启本地对话。

2. Open-WebUI云部署方案

若本地资源不足,可通过云主机(如UCloud GPU实例)快速部署:

- 选择预装Ollama-DeepSeek镜像的云主机,访问 `http://[外网IP]:8080` 配置Open-WebUI,上传知识文档并绑定模型。

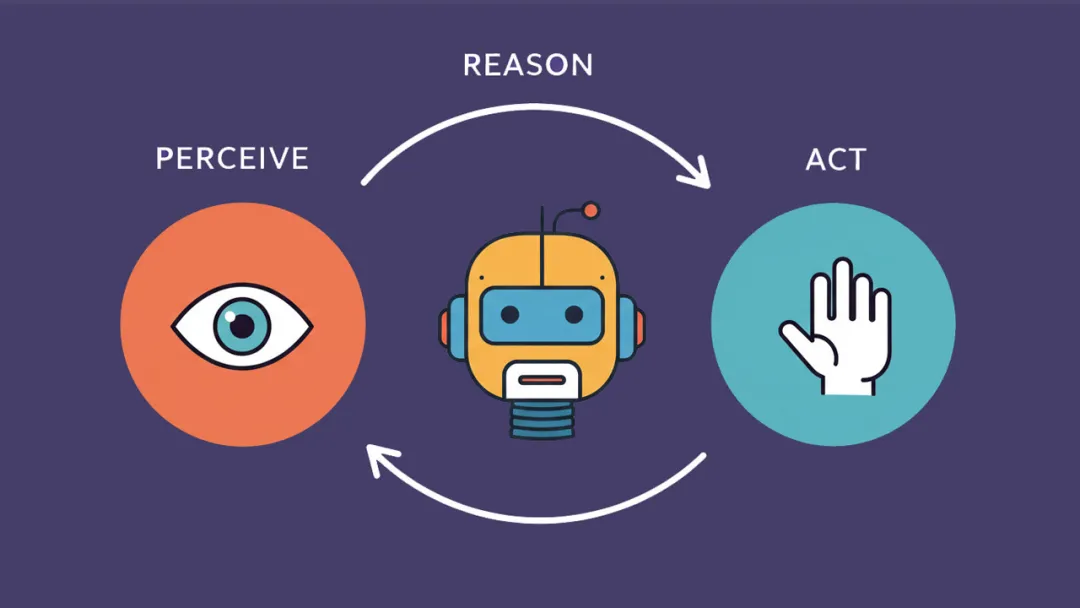

基于Dify构建知识库

1. Dify环境搭建

- 克隆Dify仓库并启动Docker容器:

git clone https://github.com/langgenius/dify.git cd dify/docker docker compose up -d

- 若拉取镜像失败,需在Docker设置中添加国内镜像源(如中科大镜像)。

2. 配置模型与知识库

- 访问 `http://localhost` 初始化Dify账号,进入“模型供应商”添加Ollama,URL填写 `http://host.docker.internal:11434`(解决Docker内部通信问题)。

- 创建知识库并上传文档(支持PDF、Word等格式),系统将自动分段处理并生成向量索引。

3. 应用集成与测试

- 在Dify中创建“聊天助手”应用,关联知识库后即可提问。例如上传医学研究报告后,输入“某病症的最新疗法”,模型将结合知识库内容生成答案。

高级功能与优化

1. 模型版本选择

7B模型:适合轻量级任务(如基础问答),显存占用低。

14B/70B模型:需更高硬件,但支持复杂推理(如长文本翻译、代码生成)。

2. 安全与隐私

- 敏感数据建议本地私有化部署,避免使用公有云API。

- 可通过Dify设置访问权限,限制知识库公开范围。

3. 性能调优

- 启用混合检索(关键词+向量)提升答案准确性。

- 定期更新知识库并重新训练嵌入模型(如bge-large)。

常见问题解决

Ollama服务无法启动:检查Docker状态或尝试重启服务。

知识库处理失败:确保文档格式正确,避免中文路径。

API响应缓慢:升级硬件或切换至蒸馏版模型(如DeepSeek-R1-1.5B)

通过Ollama+Dify的组合,用户可快速构建私有化AI知识库,适用于科研、医疗、金融等场景。若追求极简部署,云主机方案(如UCloud)能进一步降低技术门槛。需注意,官方未授权任何付费教程,建议优先参考开源文档及社区资源。

还没有评论,来说两句吧...